Se presentan las últimas novedades en procesamiento de señales de audio y en información musical

Se presentan las últimas novedades en procesamiento de señales de audio y en información musical

Al 2019 IEEE International Conference on Acoustics, Speech and Signal Processing que se celebrará del 12 al 17 de mayo en Brighton (Reino Unido), con una amplia participación de los miembros del Grupo de Investigación en Tecnología Musical: Audio Signal Processing Lab y Music Information Research Lab.

El Grupo de Investigación en Tecnología Musical (MTG), del Departamento de Tecnología de la Información y les Comunicaciones (DTIC) de la UPF, participa en la 2019 IEEE International Conference on Acoustics, Speech and Signal Processing que tendrá lugar del 12 al 17 de mayo en Brighton (Reino Unido), con los trabajos más recientes llevados a cabo en el Audio Signal Processing Lab, liderado por Xavier Serra; y en el Music Information Research Lab, liderado por Emilia Gómez.

Superando las limitaciones del aprendizaje profundo

Jordi Pons, Xavier Serra (2019), “Randomly weighted CNNs for (music) audio classification”; Jordi Pons, Joan Serrà, Xavier Serra (2019), “Training neural audio classifiers with few data”

Estableciendo un paralelismo con la neurología, las redes neuronales de la inteligencia artificial permiten generar sistemas que imitan el funcionamiento del cerebro en la forma en que este clasifica la información recibida, por ejemplo, identificando objetos en función de los rasgos que contienen. Su forma de aprendizaje contempla la retroalimentación; en sucesivas vueltas reciben el grado de acierto de sus dictámenes y realizan las correcciones oportunas. Un sistema de prueba y error del estilo que usamos los humanos en hacer una tarea nueva.

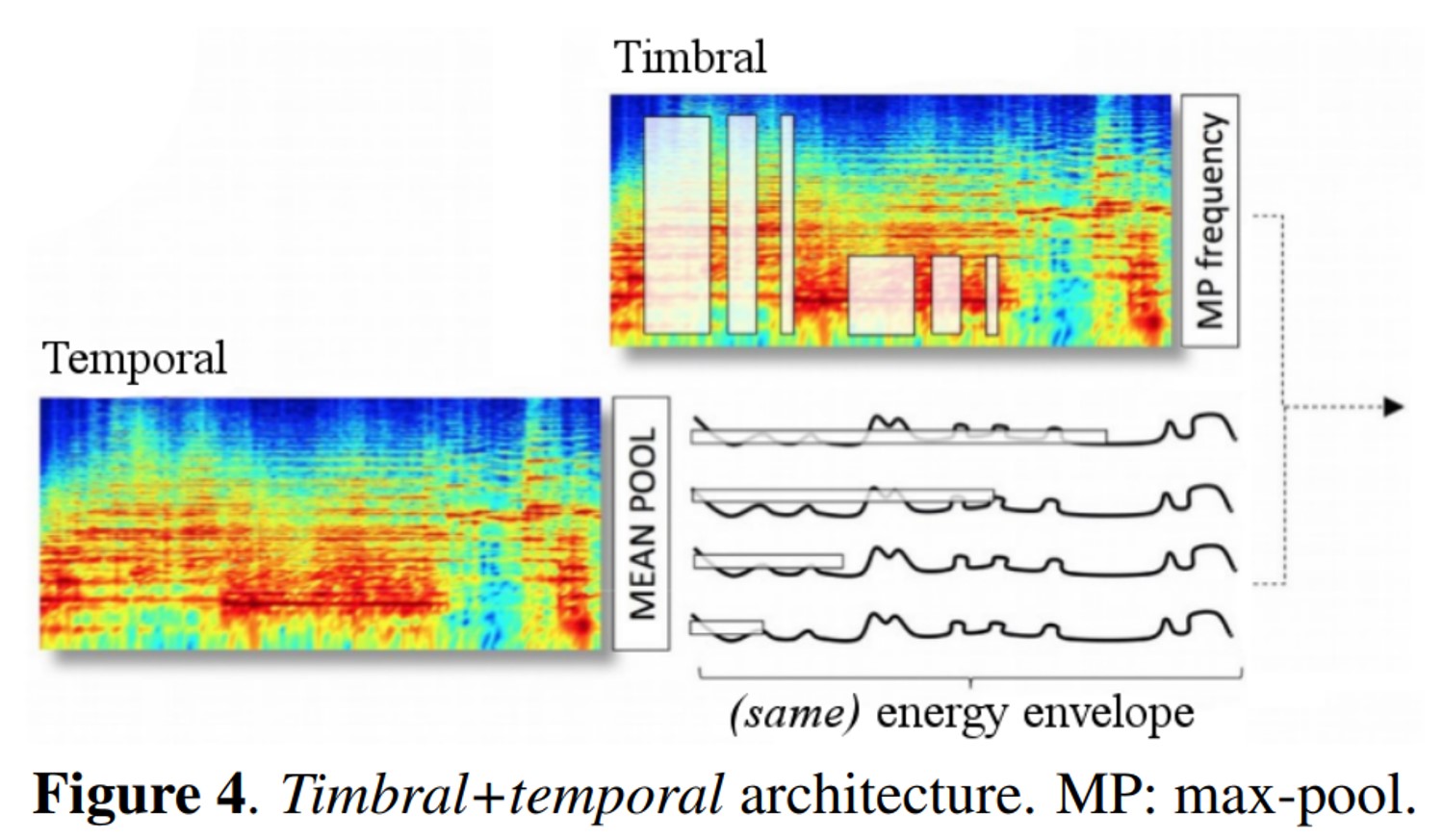

El concepto de aprendizaje profundo o deep learning hace referencia a que las redes neuronales tienen una estructura basada en numerosas capas. Las redes neuronales profundas han significado un cambio de paradigma en el campo de la clasificación automática de los sonidos. Aunque han logrado mejorar significativamente los resultados de los modelos propuestos con anterioridad, sus principales desventajas son que necesitan muchos datos de entrenamiento y que requieren de una gran infraestructura computacional.

"En los dos estudios que presentaremos al congreso intentamos comprender mejor estos dos desventajas, y nos preguntamos: ¿Podemos entrenar redes neuronales profundas con menos datos?, ¿Podemos comparar de manera cuidadosa diversas arquitecturas de redes neuronales aunque limitemos nuestros experimentos a una infraestructura computacional pequeña? En nuestros artículos mostramos que es posible entrenar modelos competentes con muy pocos datos y que también es posible comparar diversas arquitecturas de redes neuronales, a pesar de disponer de pocos recursos computacionales", explica Xavier Serra.

Métodos automáticos que mitigan el ruido de las etiquetas de audio

Eduardo Fonseca, Manoj Plakal, Daniel P.W Ellis, Frederic Font, Xavier Favory, Xavier Serra (2019), “Learning Sound Event Classifiers from Web Audio with Noisy Labels”

Para la clasificación de eventos sonoros, a medida que se utilizan colecciones de sonido más grandes, las incorrecciones (o ruido) en las anotaciones se convierten en inevitables. "En este trabajo caracterizamos el ruido de las etiquetas y proponemos métodos automáticos para mitigar sus efectos", explica Fonseca. Para llevarlo a cabo y para promover la investigación en anotaciones potencialmente incorrectas en la clasificación de eventos sonoros, los autores presentan FSDnoisy18k, una colección con 42.5 horas de audio que incorpora sonidos de 20 categorías diferentes con etiquetas potencialmente incorrectas.

Métodos de inteligencia artificial para separar fuentes sonoras

Olga Slizovskaia, Leo Kim, Gloria Haro, Emilia Gómez (2019), “End-to-End Sound Source Separation Conditioned On Instrument Labels”

En esta comunicación los autores muestran cómo separar las fuentes sonoras en señales musicales con un número de fuentes variable empleando modelos de aprendizaje profundo. En particular, los autores alargan el modelo de red Wave-U-Net a un número variable de fuentes y, además, proponen la integración en la red neuronal de etiquetas que indican presencia o ausencia de cada tipo de instrumento con lo cual se ayuda a mejorar la separación. "Este enfoque podría aplicarse también a la separación de fondo en el dominio audiovisual y la separación de fuentes a partir de una partitura musical", explica Emilia Gómez.

Clonación de timbres de voz cantada

Merlijn Blaauw, Jordi Bonada, Ryunosuke Daido (2019), “Data Efficient Voice Cloning for Neural Singing Synthesis”

En este trabajo los autores investigan la "clonación" de timbres de voz cantada a partir de un número relativamente pequeño de grabaciones. "Usando bases de datos en inglés, japonés, catalán y castellano, demostramos que con 2-3 minutos de grabación podemos obtener los mismos resultados que los que se obtenían antes con una hora de datos", explican los autores. "También investigamos el caso concreto del canto coral, en el que crear una gran cantidad de voces de manera eficiente es especialmente atractivo", añaden. Algunos ejemplos en: https://mtg.github.io/singing-synthesis-demos/voice-cloning/

Método de extracción de la voz a partir de una mezcla musical

Pritish Chandna, Merlijn Blaauw, Jordi Bonada, Emilia Gómez (2019), “A Vocoder Based Method For Singing Voice Extraction“

Este artículo se presenta un nuevo método para extraer de una mezcla musical la pista de voz. La mezcla musical consiste en una canción y una pista de acompañamiento que puede integrar diversos instrumentos. Los autores estiman los parámetros del cantante con los que sintetizan la pista vocal, sin ninguna interferencia de la pista de apoyo. "Evaluamos nuestro sistema a través de métricas objetivas de calidad de audio e interferencias de fuentes de fondos y mediante una evaluación subjetiva comparativa. Utilizamos sistemas de separación de fuentes de código abierto basados en métodos de factorización matricial no negativos (NMFs) y en métodos de aprendizaje profundo, como puntos de referencia para nuestro sistema y discutimos aplicaciones futuras para este algoritmo", explican los autores .

En el Audio Signal Processing Lab, liderado por Xavier Serra, trabajan para avanzar en la comprensión de las señales de sonido y música y abordar problemas prácticos, trabajamos en una variedad de temas complementarios que cubren la creación de colecciones de sonido y música, el desarrollo de procesos de procesamiento de señales orientados a tareas y métodos de aprendizaje automático y el uso de tecnologías semánticas para estructurar conceptos de sonido y música.

El Music Information Research Lab, liderado por Emilia Gómez, trabaja en la descripción de sonido y música, recuperación de información musical, síntesis de voz, separación de fuentes de audio, procesamiento de música y de audio. Actualmente, centrados sobre todo en la búsqueda de la síntesis y transformación de la voz, la separación de fuentes y la generación automática de paisajes sonoros.