Los algoritmos, ¿pueden predecir de manera efectiva si un joven reincidirá en su delito?

Los algoritmos, ¿pueden predecir de manera efectiva si un joven reincidirá en su delito?

Los sistemas computacionales que utilizan algoritmos de aprendizaje automático detectan patrones dentro de un ingente conjunto de datos y pueden predecir resultados complejos que presentarían un alto grado de incertidumbre. Son utilizados en múltiples ámbitos: medicina, finanzas, justicia, etc., y pueden superar las capacidades humanas, especialmente cuando se trata de grandes conjuntos de datos o del manejo de un gran número de factores.

“Un ejemplo en el que los algoritmos de aprendizaje automático y los sistemas expertos pueden informar mejor las decisiones humanas es en la predicción de reincidencia criminal, definida como el acto de una persona que comete un delito después de haber sido condenado por un delito anterior”, comenta Carlos Castillo. Sin embargo, las decisiones tomadas a partir de modelos de aprendizaje automático pueden llegar a ser injustas por presentar sesgos y discriminar a ciertos grupos minoritarios o poblaciones.

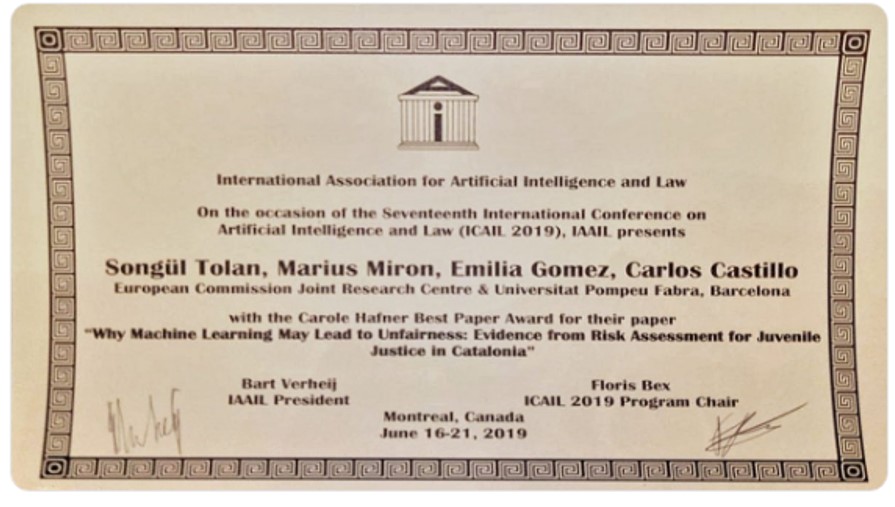

Este es el punto de partida de un trabajo de Carlos Castillo, director del grupo de investigación Ciencia Web y Computación Social (WSSC) y Emilia Gómez, investigadora de la UPF y del Joint Research Center (JRC) de la Comisión Europea, junto a Songül Tolan, Marius Miron, miembros del JRC, que se está presentando en la 17th International Conference on Artificial Intelligence and Law (ICAIL ’19), del 17–21 de junio en Montreal, Canadá y que ha ganado el Best Paper Award. Éste es un premio al mejor artículo de la conferencia y se entrega cada año en honor a la investigadora americana Carole Hafner.

Los autores proponen una metodología para evaluar la posible discriminación subyacente en los métodos de aprendizaje automático utilizados en la predicción de la reincidencia juvenil, e indican cuáles son las posibles fuentes de injusticia y discriminación. En general, un proceso o decisión se puede considerar discriminatorio si el resultado depende de la pertenencia de las personas a un grupo protegido: sexo, raza, color, idioma, religión, opinión política o de otra índole, origen nacional o social, asociación con una minoría nacional, propiedad, nacimiento u otro estatus.

Las técnicas de aprendizaje automático pueden discriminar a algunas personas si no se evalúan de forma exhaustiva, por lo que el uso de algoritmos debe hacerse de forma crítica y en colaboración con expertos en el área de la justicia

Para informar a los jueces sobre el riesgo de reincidencia de un acusado, las herramientas de evaluación de riesgos están bien establecidas a nivel mundial. Uno de los instrumentos más utilizados es la Evaluación Estructurada del Riesgo de Violencia Juvenil (SAVRY). Se utiliza para evaluar el riesgo de violencia en menores, dejando un alto grado de participación a los profesionales en la evaluación de riesgos.

Los autores han evaluado una base de datos puesta a disposición de investigadores por el Centre d'Estudis Jurídics i Formació Especialitzada (CEJFE) de la Generalitat de Catalunya que comprende observaciones de 4.753 adolescentes que cometieron delitos entre 2002 y 2010 en Catalunya y cuyo comportamiento de reincidencia se registró en 2013 y 2015. “En este trabajo estudiamos las limitaciones de los algoritmos de aprendizaje automático para predecir la reincidencia juvenil. Evaluamos la imparcialidad de los modelos de aprendizaje automático con SAVRY, en un conjunto de datos procedentes de Cataluña”, afirman los investigadores, que han comparado los modelos computacionales de aprendizaje automático con esta herramienta de evaluación de riesgos ya existente, en términos de desempeño predictivo y equidad.

Los resultados obtenidos indican que, en términos de precisión en la predicción de la reincidencia, los modelos de aprendizaje automático superan ligeramente a SAVRY, siendo todavía mejor los resultados a medida que aumentan los datos o las funciones disponibles para la capacitación. Sin embargo, en tres métricas de imparcialidad utilizadas en otros estudios, “encontramos que, en general, SAVRY es justo, mientras que los modelos de aprendizaje automático podrían llegar a discriminar por género a hombres, a extranjeros o a personas de grupos nacionales específicos”, indican los autores. “Por ejemplo, en el conjunto de datos estudiado, en comparación con los jóvenes españoles, los jóvenes extranjeros, aún sin reincidir, tienen casi el doble de probabilidades de ser clasificados erróneamente como de alto riesgo con los modelos de aprendizaje automático”, añaden.

En criminología, el uso de algoritmos, bajo ciertas condiciones, puede ser positivo

En resumen, los autores creen que el uso de algoritmos, bajo ciertas condiciones, puede ser positivo, siendo las principales contribuciones de este trabajo las siguientes:

En primer lugar, atendiendo a que la evaluación de expertos es laboriosa y que la evaluación de SAVRY es costosa, los autores han comparado el desempeño predictivo de SAVRY frente a una evaluación de riesgo generada por los métodos de aprendizaje automático basados en información sobre la demografía del acusado y la historia criminal.

En segundo lugar, han evaluado SAVRY y los modelos de aprendizaje automático en cuánto a la posible discriminación por sexo o nacionalidad.

En tercer lugar, mediante la combinación de técnicas de interpretabilidad se hace un análisis exhaustivo de los datos para discutir y elaborar las posibles causas de la disparidad existente en los métodos de aprendizaje automático.

Por último, destacar que el trabajo discute las fuentes potenciales de la posible discriminación y proporciona una explicación, mediante la combinación de técnicas de interpretabilidad del aprendizaje automático con un análisis exhaustivo de datos. “Nuestros hallazgos proporcionan una explicación de por qué las técnicas de aprendizaje automático pueden discriminar a algunas personas si no se evalúan de forma exhaustiva. Además, el uso de algoritmos tiene que hacerse de forma crítica y en colaboración con expertos en el área de la justicia”, afirman Gómez y Castillo, ambos investigadores del Departamento de Tecnologías de la Información y las Comunicaciones (DTIC) de la UPF.

Esta investigación se realiza en el marco de un convenio de colaboración subscrito entre la UPF y la Universidad de Barcelona (UB), con la colaboración especial de Antonio Andrés-Pueyo, investigador del Departamento de Psicología Clínica y Psicobiología de la UB.

Artículo de referencia:

Artículo de referencia:

Songül Tolan, Marius Miron, Emilia Gómez, Carlos Castillo (2019), “Why Machine Learning May Lead to Unfairness: Evidence from Risk Assessment for Juvenile Justice in Catalonia”, En: 17th International Conference on Artificial Intelligence and Law (ICAIL ’19), Junio 17–21, 2019, Montreal, Canadá. BEST PAPER AWARD!